2023-4-16

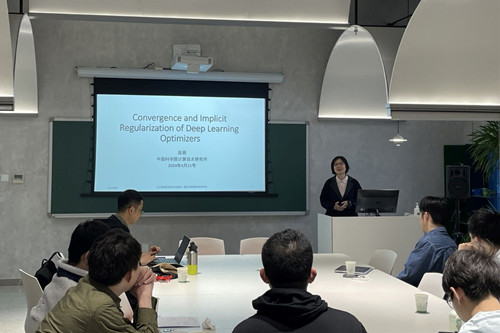

4月11日上午,由中科院数学与系统科学研究院、国家数学与交叉科学中心设立的“人工智能数学理论系列报告”举办了第八场报告会。本次活动邀请中科院计算技术研究所陈薇研究员做了题为“Convergence and Implicit Regularization of Deep Learning Optimizers”的报告,报告会由中科院数学与系统科学研究院张世华研究员主持。

深度学习模型的优化过程与泛化性能是密不可分的。在报告中,陈薇研究员从优化器的特性入手,分析深度神经网络优化器在优化过程中的收敛性能,以及基于max-margin观点对不同优化器隐式正则性的比较。首先,对损失函数L-光滑性条件进行推广,在(L0,L1)-光滑性的条件下,Adam优化器有更好的收敛性能,但SGD的收敛性很差,这解释了Adam在优化过程中通常表现更好的原因。随后,报告人对深度学习优化器的隐式正则进行分析,指出在采用齐次激活函数的深度神经网络模型中,AdaGrad优化器并不能收敛到max-margin解,而不带动量项的Adam优化器可以收敛到max-margin解。受浅层机器学习的启发,从max-margin解的角度出发,或许可以架起深度模型与泛化界之间的桥梁。

陈薇,中科院计算技术研究所研究员、博士生导师,中国科学技术大学数学科学学院兼职博士生导师。曾任微软亚洲研究院计算学习理论组负责人、理论中心共同主任。研究领域为机器学习基础理论与方法,研究兴趣包括深度学习理论、因果机器学习、分布式机器学习等。入选中科院人才引进计划、福布斯中国科技女性榜,作为骨干成员获得中科院基础研究领域青年团队计划支持。在机器学习和人工智能顶级国际会议/期刊发表学术论文60余篇,出版学术专著1本,担任ICML、NeurIPS等机器学习国际会议领域主席。